新手学习Python爬虫要了解哪些要点

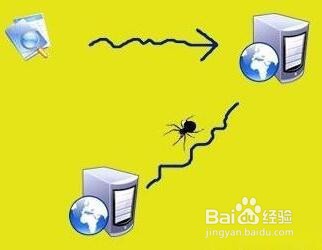

1、爬取的基本步骤 大部分爬虫都是按“发送请求——获得页面——解析页面——抽取并储存内容”这样的流程来进行,这其实也是模拟了我们使用浏览器获取网页信息的过程。简单来说,我们向服务器发送请求后,会得到返回的页面,通过解析页面之后,我们可以抽取我们想要的那部分信息,并存储在指定的文档或数据库中。在这部分你可以简单了解HTTP协议及网页基础知识,比如POSTGET、HTML、CSS、JS,简单了解即可,不需要系统学习。

3、应对反爬虫机制 当然,爬虫过程中也会经历一些绝望啊,比如被网站封IP、比如各种奇怪的验证码、userAgent访问限制、各种动态加载等等。 遇到这些反爬虫的手段,当然还需要一些高级的技巧来应对,常规的比如访问频率控制、使用代理IP池、抓包、验证码的OCR处理等等。 比如我们经常发现有的网站翻页后url并不变化,这通常就是异步加载。我们用开发者工具取分析网页加载信息,通常能够得到意外的收获。换IP必备软件兔子动态IP。

4、了解Python包 Python中爬虫相关的包很多:urllib、requests、bs4、scrapy、pyspider等,建议你从requests+Xpath开始,requests负责连接网站,返回网页,Xpath用于解析网页,便于抽取数据。 如果你用过BeautifulSoup,会发现Xpath要省事不少,一层一层检查元素代码的工作,全都省略了。掌握之后,你会发现爬虫的基本套路都差不多,一般的静态网站根本不在话下。